- Google의 PaLM 2 대형 언어 모델은 이전 모델인 LLM, CNBC에서 학습한 것보다 거의 5배 많은 텍스트 데이터를 학습에 사용합니다.

- 지난 주 PaLM 2를 발표하면서 Google은 이 모델이 이전 PaLM보다 작지만 더 효율적인 “기술”을 사용한다고 말했습니다.

- AI 모델의 교육 데이터에 대한 투명성 부족은 연구자들 사이에서 점점 더 뜨거운 주제가 되었습니다.

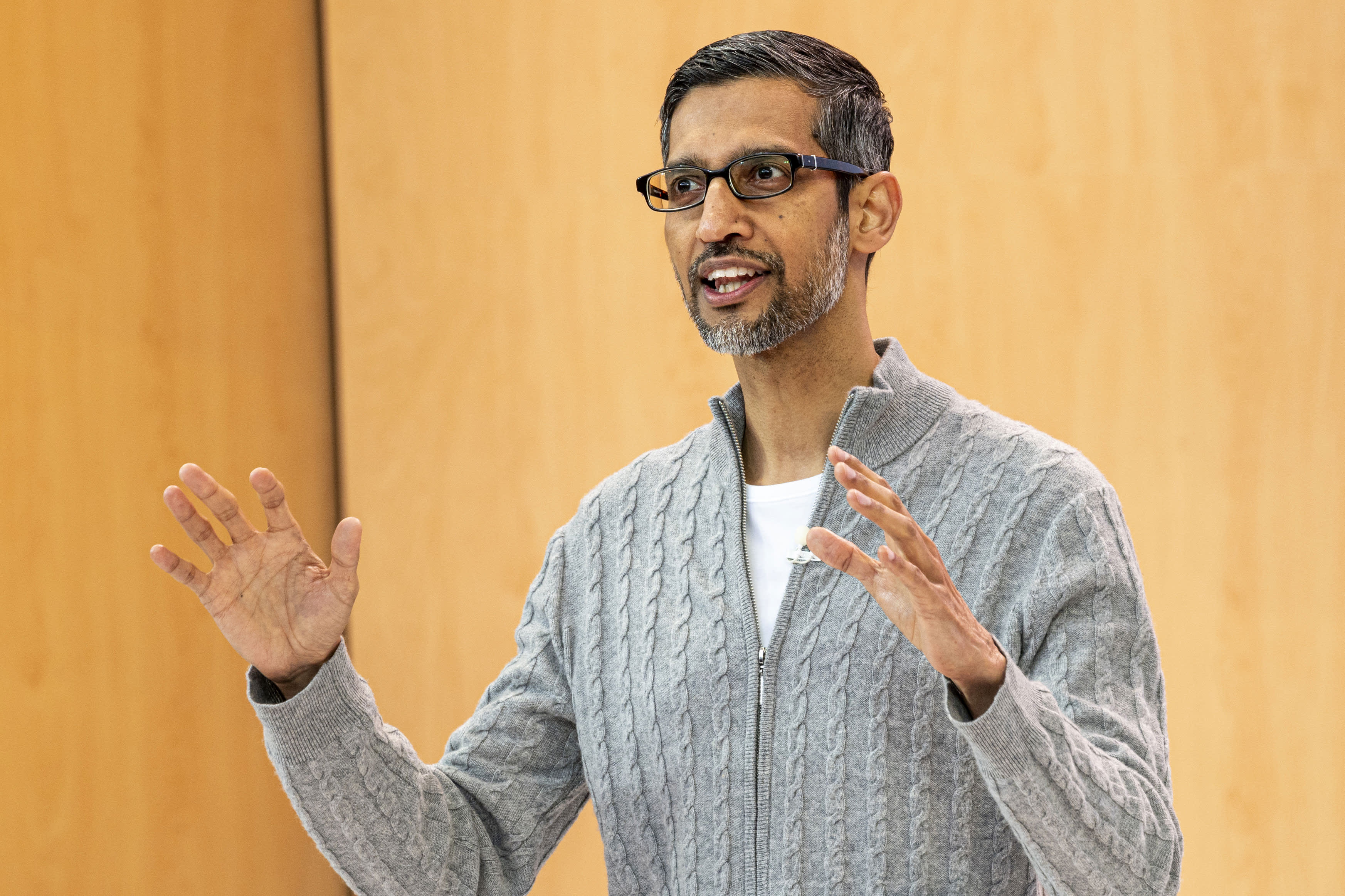

순다르 피차이 알파벳 CEO , 2023년 5월 10일 수요일 캘리포니아주 마운틴뷰에서 열린 Google I/O 개발자 회의 중.

데이비드 폴 모리스 | 블룸버그 | 게티 이미지

CNBC는 회사가 지난 주 발표한 Google의 새로운 빅 언어 모델이 2022년부터 이전 모델보다 거의 5배 많은 교육 데이터를 사용하여 더 고급 코딩, 수학 및 창의적 글쓰기 작업을 수행할 수 있다는 사실을 알게 되었습니다.

CNBC가 본 내부 문서에 따르면 Google I/O에서 공개된 회사의 새로운 공공 사용 대형 언어(LLM) 모델인 PaLM 2는 3조 6000억 개의 토큰으로 훈련되었습니다. 일련의 단어인 토큰은 시퀀스에 나타날 다음 단어를 예측하도록 모델을 가르치기 때문에 LLM 교육을 위한 중요한 구성 요소입니다.

Pathways Language Model의 약자인 Google의 PaLM 이전 버전은 2022년에 출시되었으며 7,800억 개의 토큰으로 훈련되었습니다.

Google은 AI 기술의 힘과 검색, 이메일, 워드 프로세싱 및 스프레드시트에 통합될 수 있는 방법을 보여주고 싶어했지만 훈련 데이터의 양이나 기타 세부 정보를 게시하지 않았습니다. Microsoft가 지원하는 ChatGPT의 혁신자인 OpenAI는 GPT-4라는 최신 LLM 언어의 세부 정보도 비밀로 유지했습니다.

회사는 공개가 부족한 이유가 비즈니스의 경쟁적 특성이라고 말합니다. Google과 OpenAI는 기존 검색 엔진 대신 챗봇을 사용하여 정보를 검색하려는 사용자를 유치하기 위해 서두르고 있습니다.

그러나 AI 군비 경쟁이 치열해지면서 연구계에서는 더 많은 투명성을 요구하고 있습니다.

PaLM 2를 공개한 이후 Google은 새 모델이 이전 LLM보다 작다고 밝혔습니다. 이는 회사의 기술이 더 복잡한 작업을 수행하면서 더 효율적이 되고 있음을 의미하기 때문에 중요합니다. 내부 문서에 따르면 PaLM 2는 모델의 복잡성을 나타내는 3400억 개의 매개변수에 대해 교육을 받았습니다. 초기 PaLM은 5400억 개의 매개변수에 대해 훈련되었습니다.

Google은 이 이야기에 대해 즉시 의견을 제공하지 않았습니다.

Google 그는 말했다 PaLM 2에 대한 블로그 게시물에서 모델은 Computational Scale Optimization이라는 “새로운 기술”을 사용합니다. 따라서 LLM은 “더 빠른 추론, 더 적은 서비스 매개변수 및 더 낮은 서비스 비용을 포함하여 전반적으로 더 나은 성능으로 더 효율적”입니다.

PaLM 2를 발표하면서 Google은 모델이 100개 언어로 학습되고 다양한 작업을 수행한다는 이전 CNBC 보고서를 확인했습니다. 회사의 실험적인 챗봇 Bard를 포함하여 이미 25개의 기능과 제품을 구동하는 데 사용되고 있습니다. Gecko, Otter, Bison 및 Unicorn의 네 가지 크기로 제공됩니다.

PaLM 2는 공개된 내용을 바탕으로 기존의 어떤 모델보다 강력합니다. Facebook의 LLM은 LLaMA라고 합니다. 발표하다 2월에는 1조 4천억 개의 토큰으로 훈련되었습니다. OpenAI가 ChatGPT 교육량을 마지막으로 공유한 것은 GPT-3에서 당시 3000억 개의 코드를 교육했다고 밝혔습니다. OpenAI는 지난 3월 GPT-4를 출시했으며 여러 전문 테스트에서 “인간 수준의 성능”을 보인다고 밝혔다.

Google에서 LaMDA, LLM 대화 발 CNBC가 본 최신 문서에 따르면 2년 전 Bard와 함께 2월에 홍보되었으며 1조 5천억 개의 토큰으로 훈련되었습니다.

새로운 AI 애플리케이션이 빠르게 주류에 도달함에 따라 기본 기술에 대한 논쟁도 마찬가지입니다.

Mehdi Elmohamady, Google 선임 연구 과학자, 그는 2월에 사임했다 회사의 투명성 부족에 대해. 화요일 OpenAI CEO Sam Altman은 개인 정보 보호 및 기술에 관한 상원 사법부 소위원회 청문회에서 증언하고 AI를 처리하기 위해 새로운 시스템이 필요하다는 의원들과 동의했습니다.

“매우 새로운 기술을 위해서는 새로운 프레임워크가 필요합니다.”라고 Altmann은 말했습니다. “확실히 우리와 같은 회사는 우리가 세상에 내놓는 도구에 대해 많은 책임을 지고 있습니다.”

— CNBC의 Jordan Novette가 이 보고서에 기여했습니다.

그는 지켜본다: OpenAI의 CEO인 Sam Altman은 AI 관리를 촉구했습니다.

“맥주 괴짜. 사악한 대중 문화 닌자. 평생 커피 학자. 전문 인터넷 전문가. 육류 전문가.”

/cdn.vox-cdn.com/uploads/chorus_asset/file/25415361/Adobe_VideogigaGAN_hed_hero.jpg)